🦙 Ollama ya puede ejecutar modelos LLM multimodales

Ya está disponible la versión de llava en https://ollama.com/library/llava… y yo me he preguntado si con todo el revuelo que hay con la Generative AI estas últimas semanas, este modelo de andar por casa es capaz de dar el nivel.

Lo he enviado en la bioguagua a estudiar Bio-Medicina a la universidad y le he marcado algunas tareas, ejecutando una consulta multimodal sobre una imagen en disco con ollama run llava "what is in this image? /users/me/images/myimage.jpg"

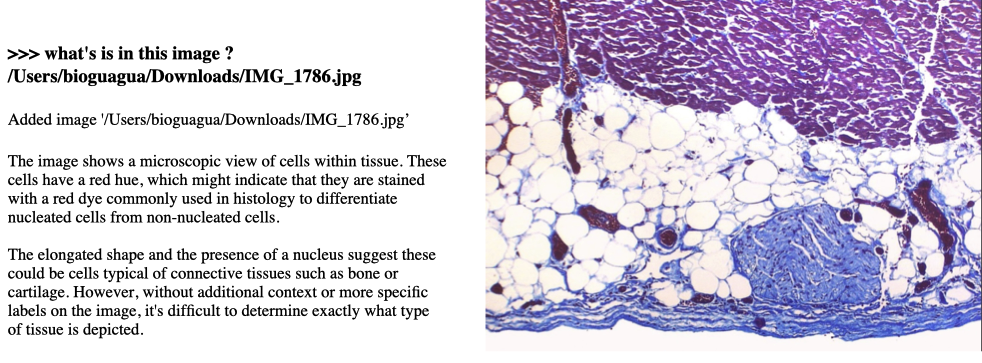

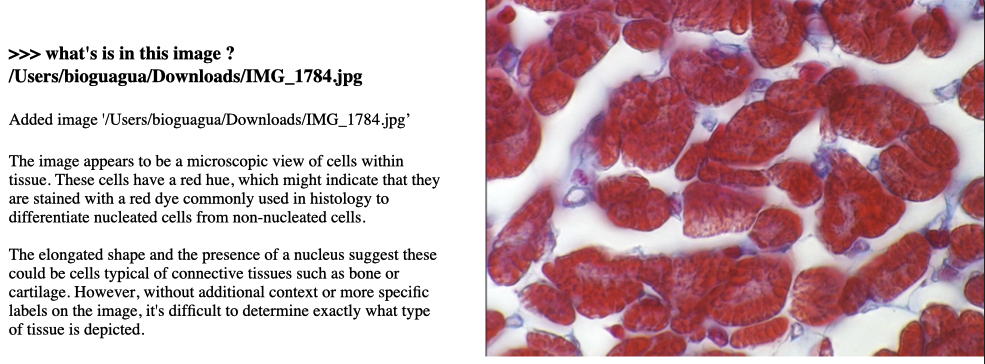

A lo que me ha respondido:

Aunque muestra intención de querer responder algo relacionado con la imagen, y hace un gran esfuerzo, ha suspendido. Me pregunto qué potencia tendrán los modelos realmente buenos, no los liberados como Open Source.

Todavía no podemos encargarle la misión de llevar automáticamente el contenido del canal de Instagram BioGuagua.